有朋友提到网站被百度抓取的频次很低,问怎么解决。抓取频次对页面收录的影响很大,如果网站抓取频次很低,意味着有很页面没有被抓取到,这就大大影响了页面收录。

网站百度抓取频次太低怎么办

网站百度抓取频次太低怎么办

怎么解决网站抓取频次低的问题呢,我们不妨试试以下办法。

一、通过网站设置解决抓取频次低的问题

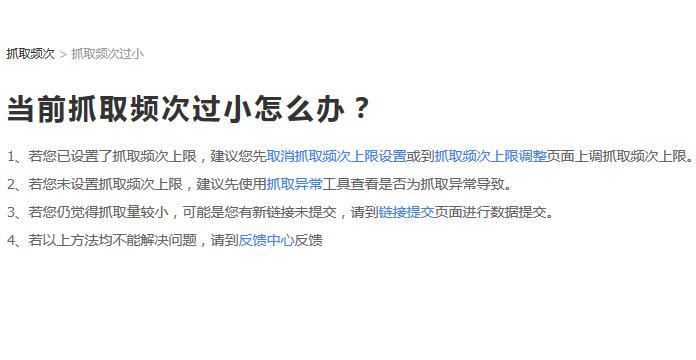

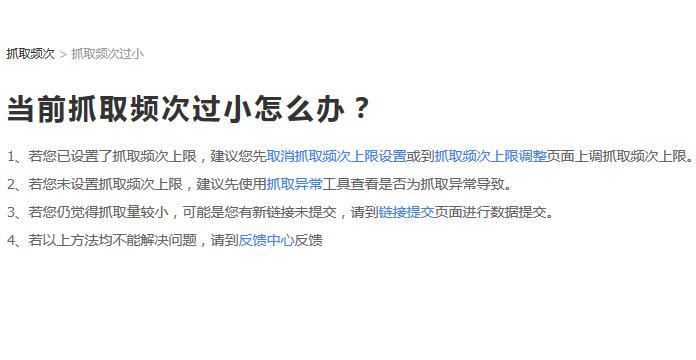

在百度站长平台(现以改名为百度搜索资源平台)里有针对抓取频次过少的解决说明,如下图:

网站百度抓取频次太低怎么办

网站百度抓取频次太低怎么办

笔者在这里稍作解释:1.正常而言站长不会去主动设置抓取频次上限,所以这点不用考虑;2.检查是否抓取异常,这需要注意,有些网站程序可能存在一些错误导致抓取不成功;3.提交新链接,这点挺实用;4.反馈,对于反馈应该说基本没啥作用。

大家应该着重注意第2点和第3点。

二、通过外链解决抓取频次低的问题

抓取频次高低在某种意义上取决于蜘蛛爬行的次数,爬行的次数多页面被抓取才会多,正常情况下这是成正比的。

对于权重低的网站来说,通过做外链吸引蜘蛛爬行是个不错的选择。笔者在现在做seo发外链还有效果吗一文中也有所提及。

PS:这里需要解释下蜘蛛爬行的概率,百度蜘蛛并非是能够吐丝结网的蜘蛛,它的工作原理是在整理好的url库中通过具体的url链接抓取该页面数据,同时将页面里的链接提取出来,过滤后将剩下的url地址被放入到url库,这是一个循环的过程。

通过建设外链让我们网站的url更多的被百度蜘蛛发现及入库,这就可以有更多的机会提高抓取频次。

三、通过内链建设解决抓取频次低的问题

上面提到建设外链可以吸引蜘蛛爬行,那么在蜘蛛来了以后如何更好的利用,如何让更多的页面url被发现,这就牵扯到内链建设。如何设置内容提高抓取频次,我们可以从以下几个方面入手:

1.文章内链。包括正文里的内链及相关文章推荐等,这是基本的操作方式,笔者就不多说了。

2.边栏推荐。比如说热门阅读、最新内容、tag集合标签推荐等,页面链接曝光的越多,被蜘蛛抓取的几率就越大,这是很简单的道理。

3.文章列表。这是需要重点讲解,正常情况下列表里的文章都是按照时间顺序倒叙排列,也就是说后发布的文章排在最前面。这里就存在一个问题,同一个文章列表下每天更新的文章有限,而分页被蜘蛛抓取的次数会相对较多,这就浪费了链接展现的机会。

举个例子说明:A列表展示最新的10篇文章,每天更新的数量为5篇,蜘蛛每天爬行5次。事实上不管蜘蛛每天爬行5次还是50次,该页面每天展现的新的页面链接都只有5个!假如该分类页能够把没有被抓取的页面更新上来(定时或不定时都行),那情况明显就不一样了,每次蜘蛛来抓取都有新的页面链接提交,这就大大提高了抓取频次。

网站更新频率高的网站更受蜘蛛青睐,想要解决网站抓取频次低的问题,除了做外链吸引蜘蛛,更多的应该解决站内更新的问题。

PS:页面更新并非绝对指新页面的增加,对搜索引擎蜘蛛来说,页面的内容变了就意味着页面更新了,至于更新后页面质量是否提升,本文暂不展开细说。

还有一点就是网站本身内容的数量,若是网站页面总数不过100,还要求每日抓取量上千,这明显是脱离实际了。